Core MLとは

最新のiOS11には、機械学習のフレームワークとして、Core MLが搭載されています。

MLとはMachine Learningですね。

機械学習の定義を調べてみると、結構あいまいですが、要はいろんなデータを与えることで、その先を予測させることのようです。

例えば、歴史上の全世界の株価のデータをあらかじめ与えてやれば、そこから将来の株価の予測が建てられるようになります。

もちろん予測なので、100%当たるかどうかはわかりません。

与えるデータの精度や、予測する内容によって変化すると思います。

で、Apple Storeにさっそく、Core MLを利用したアプリが登録されているので、ダウンロードしてみました。

有料ですが、120円ですので、話のタネにダウンロード。

話すカメラ

それが、この、話すカメラです。

このアプリは、カメラに映るあらゆる物体の名前を判定して答えてくれます。

しかもかなり高速に。と言うか、ほぼリアルタイムです。

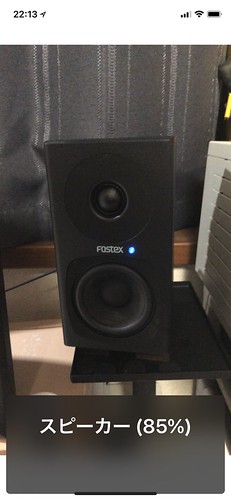

例えば、スピーカーを映せば、すぐに、

「スピーカー」

と発音してくれます。

あらかじめ、膨大なデータが内蔵されていて、それと一致すれば、その物体名を発音するだけですが、考えてみれば、まさに機械学習ですね。

あらかじめスピーカーの外観をデータとして持っていて、映った映像がそれと一致すれば、それがスピーカーであると判断して、発音するわけです。

このように、画面には、一致率が表示されます。

他のモノも片っ端から試してみました。

他にも、フライパン、エスプレッソマシーン、掃除機、リモコン、ライター、デジタル時計、封筒、キャンドル、常備薬戸棚、蚊帳、クロスワードパズル、トイレスッポンなど、まあとにかく、いろんなモノを認識します。

例えば、目の不自由な人が目の前の物体を認識するのに役立ちそうです。

将来、もっと技術が進化すれば、日常生活に入り込んでくるんでしょうね。

もちろん機械学習単体では無く、AIなんかと組み合わせられるのでしょう。

自動車の自動運転なんて、その頂点かもしれません。

その一端をiPhoneで垣間見ることのできるアプリです。

外へ持ち出して、いろんなモノで試してみたいです。